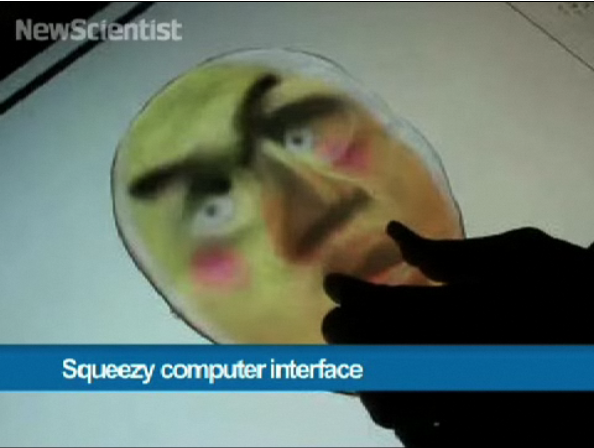

얼마 전에 올린 polarization과 관련해서 글을 쓰던 중에, 아래와 같은 동영상을 발견했다. 지난 달 New Scientist지에 소개된 일본 전기통신대학의 "Squeezable" Tangible UI 사례.

조금은 기괴해 보이는 데모지만, 원리를 생각해 보면 상당히 재미있는 구석이 있다. 원래 LCD에서 나오는 빛은 편광성을 가지고 있는데, 그 위에 압력(stress)을 가하면 편광을 왜곡시킬 수 있는 투명한 고무덩어리를 올려놓고 그걸 눌러 LCD 화면으로부터의 편광을 분산시킨다. 카메라에서는 LCD 화면과 편광 축이 수직인 필터를 사용하고, 그러면 아무 것도 안 보이다가 분산된 편광 부분만, 그것도 분산된 만큼 - 즉, 압력이 가해지면 확률적으로 더 많은 부분이 분산되어 - 카메라에 보이게 된다는 것이다. ... 참 별 생각을 다 해냈다. -_-a;;

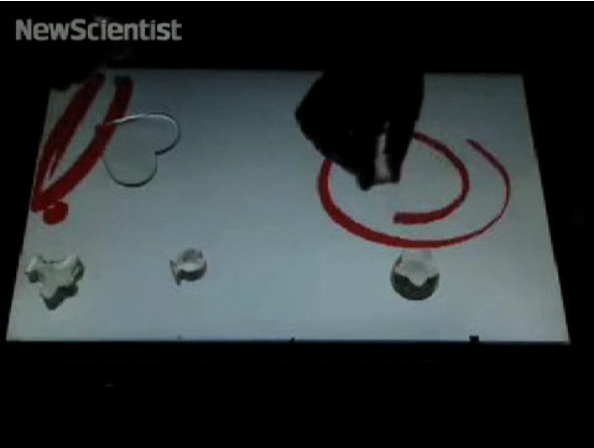

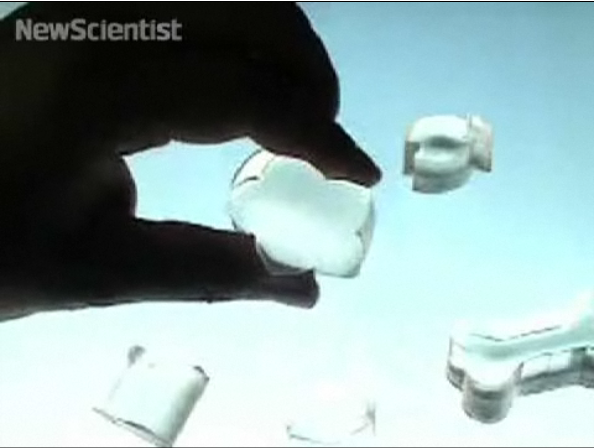

Tangibles 자체에 가해진 압력만으로 입력의 정도를 조정할 수 있어서, 위 동영상에서처럼 화면과 떨어진 상태에서 조작함으로써 물감을 쥐어짜 화면에 흘리는 것과 같은 인터랙션이 가능하다는 점은 기존의 TUI 연구와 차별되는 점이라고 생각한다. 특히 물체를 쥐는 동작은 근대 GUI에 은근히 많이 적용된 metaphor이므로, 이를테면 drag-and-drop을 말 그대로 "집어들어 옮겨놓기"로 구현할 수 있다는 점은 재미있을듯.

특히 압력을 기반으로 입력이 이루어지기 때문에 터치스크린의 단점인 "오터치" 혹은 사용자가 의도하지 않은 터치 입력을 방지할 수 있다는 점은 주목할 만하다. 정확성을 기대할 순 없지만 deep touch의 입력방식 중 하나로 사용할 수도 있겠다.

그래도 결국 카메라가 화면 바깥에 있어야 하므로 결국 설비가 커지는 고질적인 제약사항은 여전히 가지고 있고, 편광된 광원이 필요하므로 LCD 화면으로부터의 빛이 보이는 영역에서만 조작할 수 있다는 한계가 있을테고, 무엇보다 여러 물체를 동시에 인식할 수 없을 듯한 점(고무에 색깔을 넣어서 인식한다고 해도 극단적인 원색 몇가지로 제한될 듯) 등은 아쉬운 일이다. 후에 뭔가 딱 맞는 사용사례를 만나게 될지는 모르지만, 지금으로선 그냥 스크랩이나 해두기로 했다.

그나저나, 처음 들어본 학교 이름인지라 한번 검색해 보니, 대표 연구자인 Hideki Koike는 전기통신대학의 교수로 위와 같이 영상인식을 통한 HCI 뿐만 아니라 정보 보안이나 Info Viz, 프랙탈 시각화에 대한 연구도 수행하고 있는 사람이다. 그 중에서 위 연구가 포함되어 있는 "Vision-based HCI" 페이지를 보면 2001년에 수행한 손 위치/자세 추적 연구부터 최근의 연구 - "Photoelastic Touch"라는 제목으로 발표된 듯 - 까지 나열되어 있는 걸 볼 수 있다.

최근의 연구를 보면 재미있는 게 좀 있는데, 이를테면 역시 LCD 화면의 편광성을 이용해서 투명한 AR Tag를 만든 사례같은 경우에는 일전에 Microsoft에서 데모했던 SecondLight의 구현원리를 조금 더 발전시킨 것으로 보인다.

요즘에는 공대에서 나온 HCI 연구도 제법 잘 꾸며서 나오건만, 이 학교에서 나온 결과물들은 그 가능성에 비해서 시각적인 면이 조악해서 별로 눈에 띄지 않았나보다. 너무 유명해져서 일할 시간이 없는 사람들보다, 이렇게 눈에 띄지 않았던 연구팀과 협력할 일이 생긴다면 뭔가 독창적인 성과를 낼 수 있을까. OLED가 뜨면서 사양길인가 싶은 LCD의 단점을 인터랙션 측면의 장점으로 바꿀 수 있을지도.

|

|

|

조금은 기괴해 보이는 데모지만, 원리를 생각해 보면 상당히 재미있는 구석이 있다. 원래 LCD에서 나오는 빛은 편광성을 가지고 있는데, 그 위에 압력(stress)을 가하면 편광을 왜곡시킬 수 있는 투명한 고무덩어리를 올려놓고 그걸 눌러 LCD 화면으로부터의 편광을 분산시킨다. 카메라에서는 LCD 화면과 편광 축이 수직인 필터를 사용하고, 그러면 아무 것도 안 보이다가 분산된 편광 부분만, 그것도 분산된 만큼 - 즉, 압력이 가해지면 확률적으로 더 많은 부분이 분산되어 - 카메라에 보이게 된다는 것이다. ... 참 별 생각을 다 해냈다. -_-a;;

|

|

Tangibles 자체에 가해진 압력만으로 입력의 정도를 조정할 수 있어서, 위 동영상에서처럼 화면과 떨어진 상태에서 조작함으로써 물감을 쥐어짜 화면에 흘리는 것과 같은 인터랙션이 가능하다는 점은 기존의 TUI 연구와 차별되는 점이라고 생각한다. 특히 물체를 쥐는 동작은 근대 GUI에 은근히 많이 적용된 metaphor이므로, 이를테면 drag-and-drop을 말 그대로 "집어들어 옮겨놓기"로 구현할 수 있다는 점은 재미있을듯.

특히 압력을 기반으로 입력이 이루어지기 때문에 터치스크린의 단점인 "오터치" 혹은 사용자가 의도하지 않은 터치 입력을 방지할 수 있다는 점은 주목할 만하다. 정확성을 기대할 순 없지만 deep touch의 입력방식 중 하나로 사용할 수도 있겠다.

그래도 결국 카메라가 화면 바깥에 있어야 하므로 결국 설비가 커지는 고질적인 제약사항은 여전히 가지고 있고, 편광된 광원이 필요하므로 LCD 화면으로부터의 빛이 보이는 영역에서만 조작할 수 있다는 한계가 있을테고, 무엇보다 여러 물체를 동시에 인식할 수 없을 듯한 점(고무에 색깔을 넣어서 인식한다고 해도 극단적인 원색 몇가지로 제한될 듯) 등은 아쉬운 일이다. 후에 뭔가 딱 맞는 사용사례를 만나게 될지는 모르지만, 지금으로선 그냥 스크랩이나 해두기로 했다.

그나저나, 처음 들어본 학교 이름인지라 한번 검색해 보니, 대표 연구자인 Hideki Koike는 전기통신대학의 교수로 위와 같이 영상인식을 통한 HCI 뿐만 아니라 정보 보안이나 Info Viz, 프랙탈 시각화에 대한 연구도 수행하고 있는 사람이다. 그 중에서 위 연구가 포함되어 있는 "Vision-based HCI" 페이지를 보면 2001년에 수행한 손 위치/자세 추적 연구부터 최근의 연구 - "Photoelastic Touch"라는 제목으로 발표된 듯 - 까지 나열되어 있는 걸 볼 수 있다.

최근의 연구를 보면 재미있는 게 좀 있는데, 이를테면 역시 LCD 화면의 편광성을 이용해서 투명한 AR Tag를 만든 사례같은 경우에는 일전에 Microsoft에서 데모했던 SecondLight의 구현원리를 조금 더 발전시킨 것으로 보인다.

요즘에는 공대에서 나온 HCI 연구도 제법 잘 꾸며서 나오건만, 이 학교에서 나온 결과물들은 그 가능성에 비해서 시각적인 면이 조악해서 별로 눈에 띄지 않았나보다. 너무 유명해져서 일할 시간이 없는 사람들보다, 이렇게 눈에 띄지 않았던 연구팀과 협력할 일이 생긴다면 뭔가 독창적인 성과를 낼 수 있을까. OLED가 뜨면서 사양길인가 싶은 LCD의 단점을 인터랙션 측면의 장점으로 바꿀 수 있을지도.

반응형