마이크로소프트에서 멀티터치 스마트 테이블를 들고 나오면서 한동안 소위 'Surface Computing'이라는 요상한 용어를 뿌리더니(예전에 같이 일했던 어떤 분은 분명히 "표면이 computing하는 것도 표면을 computing하는 것도 아닌데 무슨 surface computing이냐!!!"라고 하고 계실 거다), 이번엔 'Sphere'라는 코드명을 들고 나왔다. 요컨대 멀티터치가 되는 구형의 화면이다.

흠. 결국 했구나. ㅡ_ㅡa;;

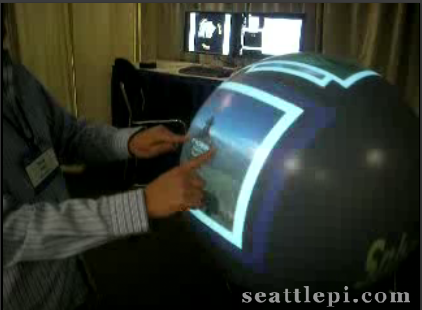

데모하고 있는 사람 너머로 보이는 화면을 보면, 왼쪽의 큰 화면은 결국 프로젝션 되고 있는 화면으로 원형으로 투사될 수 있도록 미리 왜곡되어 있고, 오른쪽 화면에 보이는 모습들 중 가운데 화면은 적외선 반사에 의한 포인팅을 인식하는 모습을 보여주고 있다. (특히 아래 장면에서는 두 손가락이 화면에 찍혀 있는 모습을 볼 수 있다... 잘 보면 =_= )

결국 Surface 시스템에 있던 입출력 장치 앞에 어안렌즈를 하나 넣어서, 프로젝션도 카메라도 180도 가까이 퍼지게 만든 것으로 보이는데, 사실 그럼에도 불구하고 몇가지 의문이 남는 부분이 있다. 이를테면 프로젝션의 초점거리 같은 경우가 대표적인데, 180도 퍼지게 만든 화면을 투사한다고 해도 구체 아랫쪽의 투사면과 맨 위쪽의 투사면까지의 거리는 크게 다르기 때문에 골고루 또렷한 영상을 맺히게 하기 힘들 거다. (초점거리 개념이 없는 프로젝터가 개발되어 있기는 하지만, 저렇게 바깥쪽으로 사람을 향해서 투사할 수는 없는 물건이다 -_- )

그 외에 적외선 반사를 이용한 인식의 해상도라든가, 상을 왜곡시키기 위해 평면 좌표계를 실시간으로 구좌표계로, 또 반대로 계산하는 번거로움이라든가 하는 것들도 문제가 될 수 있겠지만, 사실 실용성 측면에서 볼 때 가장 큰 문제는 역시 투사된 화면의 위치에 따른 해상도 차이라고 본다.

... 사실은 그게 내가 못 풀었던 문제다. 그래서 난 @#$%@%@#$%^$#^&#%^&렇게 피해서 도망갔더랬는데, 얘네들은 혹시 풀었는지, 풀었다면 어떻게 풀었는지가 아주 궁금해 죽겠다. ~_~ ㅎㅎ

흠. 결국 했구나. ㅡ_ㅡa;;

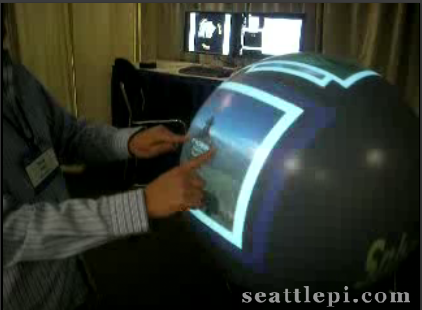

데모하고 있는 사람 너머로 보이는 화면을 보면, 왼쪽의 큰 화면은 결국 프로젝션 되고 있는 화면으로 원형으로 투사될 수 있도록 미리 왜곡되어 있고, 오른쪽 화면에 보이는 모습들 중 가운데 화면은 적외선 반사에 의한 포인팅을 인식하는 모습을 보여주고 있다. (특히 아래 장면에서는 두 손가락이 화면에 찍혀 있는 모습을 볼 수 있다... 잘 보면 =_= )

결국 Surface 시스템에 있던 입출력 장치 앞에 어안렌즈를 하나 넣어서, 프로젝션도 카메라도 180도 가까이 퍼지게 만든 것으로 보이는데, 사실 그럼에도 불구하고 몇가지 의문이 남는 부분이 있다. 이를테면 프로젝션의 초점거리 같은 경우가 대표적인데, 180도 퍼지게 만든 화면을 투사한다고 해도 구체 아랫쪽의 투사면과 맨 위쪽의 투사면까지의 거리는 크게 다르기 때문에 골고루 또렷한 영상을 맺히게 하기 힘들 거다. (초점거리 개념이 없는 프로젝터가 개발되어 있기는 하지만, 저렇게 바깥쪽으로 사람을 향해서 투사할 수는 없는 물건이다 -_- )

그 외에 적외선 반사를 이용한 인식의 해상도라든가, 상을 왜곡시키기 위해 평면 좌표계를 실시간으로 구좌표계로, 또 반대로 계산하는 번거로움이라든가 하는 것들도 문제가 될 수 있겠지만, 사실 실용성 측면에서 볼 때 가장 큰 문제는 역시 투사된 화면의 위치에 따른 해상도 차이라고 본다.

... 사실은 그게 내가 못 풀었던 문제다. 그래서 난 @#$%@%@#$%^$#^&#%^&렇게 피해서 도망갔더랬는데, 얘네들은 혹시 풀었는지, 풀었다면 어떻게 풀었는지가 아주 궁금해 죽겠다. ~_~ ㅎㅎ

반응형