물리적인 조작장치를 넘어서기 - Part 2

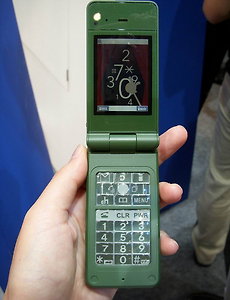

이 글은 시리즈 글이 아닐 뿐더러, Part 2 - 그 후의 이야기를 언젠가 쓰면 좋겠다 싶긴 했지만 이런 소재로 쓰게 될 줄은 몰랐다. 언제나 사실은 간단명료하다. "키 탑은 투명한 수지로, 개개의 키아래에 전자 페이퍼가 설치되어 있다. 전원 오프 상태에서는, 전원 키만이 표시되고 있다. 전원 키를 눌러 대기 모드가 되면, 통상의 휴대전화와 같이 아이콘이나 숫자가 키에 표시된다. 메뉴 선택시에는 십자 키의 표시가 아이콘으로부터 화살표로 바뀌어, 계산기 모드에서는 십자 키가 사칙 연산용의 표시가 된다. 또, 메일 입력시에는, 히라가나, 카타카나, 영문자, 숫자의 각각의 모드에 응해 표시가 바뀐다. (중략) 「그 때 필요한 만큼의 버튼을 전자 페이퍼에 표시하므로, 헤매는 것이 없고 알기 쉽다. 편안한 폰과..

2007. 10. 4.

물리적인 조작장치를 넘어서기 - Part 2

이 글은 시리즈 글이 아닐 뿐더러, Part 2 - 그 후의 이야기를 언젠가 쓰면 좋겠다 싶긴 했지만 이런 소재로 쓰게 될 줄은 몰랐다. 언제나 사실은 간단명료하다. "키 탑은 투명한 수지로, 개개의 키아래에 전자 페이퍼가 설치되어 있다. 전원 오프 상태에서는, 전원 키만이 표시되고 있다. 전원 키를 눌러 대기 모드가 되면, 통상의 휴대전화와 같이 아이콘이나 숫자가 키에 표시된다. 메뉴 선택시에는 십자 키의 표시가 아이콘으로부터 화살표로 바뀌어, 계산기 모드에서는 십자 키가 사칙 연산용의 표시가 된다. 또, 메일 입력시에는, 히라가나, 카타카나, 영문자, 숫자의 각각의 모드에 응해 표시가 바뀐다. (중략) 「그 때 필요한 만큼의 버튼을 전자 페이퍼에 표시하므로, 헤매는 것이 없고 알기 쉽다. 편안한 폰과..

2007. 10. 4.