딱이 UI에 대한 내용은 아닐지 몰라도, 여러 유용한 기술의 작동원리를 알아둔다는 것은 두고두고 도움이 된다. 특히 기술을 앞장서서 적용하는 HTI의 관점을 생각해 보면 더욱 더. 일전에 iPhone 카메라에 초점조절이 들어간 걸 보고 액체렌즈가 벌써 상용화됐나 하면서 호들갑을 떤 적이 있는데, 얼마전 관련기사를 읽다가 "아이폰에 카메라 센서를 공급한 'OmniVision'사..."라는 대목을 보고 뒷조사(라고 쓰고 구글링이라고 읽는다)에 들어갔다.

인터넷을 보니 이 회사가 아이폰에 카메라 센서(CMOS Image Sensor)를 독점적으로 제공하고 있는 것에 대해서는 오래전부터 많은 기사가 있었던 듯. 단지 그 모든 기사들이 아이폰의 다른 전자부품들과 마찬가지로 그냥 그걸 어느 회사가 공급하기로 계약했다더라..라는 점만 언급할 뿐, 왜 옴니비전이 선택됐는지는 자세히 나와있지 않다.

인터넷을 보니 이 회사가 아이폰에 카메라 센서(CMOS Image Sensor)를 독점적으로 제공하고 있는 것에 대해서는 오래전부터 많은 기사가 있었던 듯. 단지 그 모든 기사들이 아이폰의 다른 전자부품들과 마찬가지로 그냥 그걸 어느 회사가 공급하기로 계약했다더라..라는 점만 언급할 뿐, 왜 옴니비전이 선택됐는지는 자세히 나와있지 않다.

OmniVision Technologies의 웹사이트를 구석구석 읽어보면, 중간중간 나타나는 TrueFocus(TM)라는 기술이 아마도 그 핵심이 아닐까 싶다. 이 기술에 대해서는 뭐 당연히... 웹사이트에 친절하게 설명되어 있지는 않지만, 사이트 한 구석을 보면 자회사로 등록되어 있는 OmniVision CDM Optics Inc.에서 Wavefront Coding(TM) Technology 라는 걸 이용해서 소형 카메라의 초점범위를 넓히는 기술을 특허로 가지고 있다는 걸 알 수 있다. 그래도 바로 특허검색.

... 결과는, 앞서 액체렌즈 운운했던 내가 바보같이 느껴지는 내용들이다.

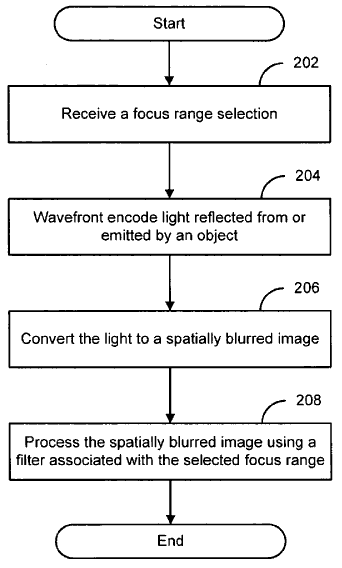

특허 내용 자체는 일주일 넘게 껴안고 짬짬이 읽어봤지만 나로서는 100% 이해하는 게 불가능. 예전 같으면 광학 전문가가 같은 건물 어딘가에 있어서 도움을 받았겠지만, 지금은 주변 동료들의 전문분야가 훨씬 더 다양해지는 바람에 공학 전문가를 찾기가 오히려 힘든 상황이니 뭐. ㅡ_ㅡa;; ... 해서 포기하고, 그냥 몇가지 그림이나 따다놓고 내가 이해한 내용이나 정리해 두기로 했다. 기술에 대한 자세한 (그리고 아마도 올바른) 설명은 위키피디아나 CDM Optics사 웹사이트에 설명되어 있으며, 관련논문(1, 2)도 올라와 있다.

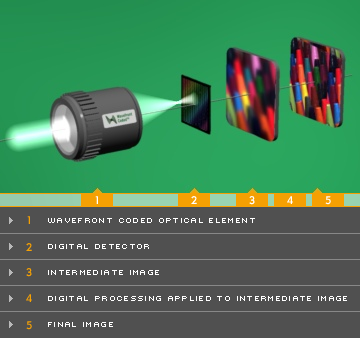

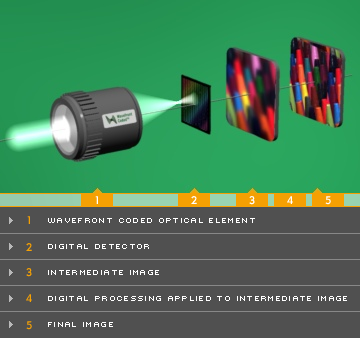

이 wavefront coding에 대한 그나마 해독 -_- 가능했던 설명은 위 CDM Optics사에서 찾아볼 수 있었는데, "특별하게 깎은 렌즈를 통과해서 의도적으로 산란시킨(encoding) 빛을, 그 렌즈의 산란을 역으로 계산하는 알고리듬으로 다시 원래의 영상으로 변환함으로써(decoding), 초점의 깊이/심도를 소프트웨어 적으로 유연하게 조절하고 사진의 전반적인 품질을 높일 수 있는 기술"인 듯 하다.

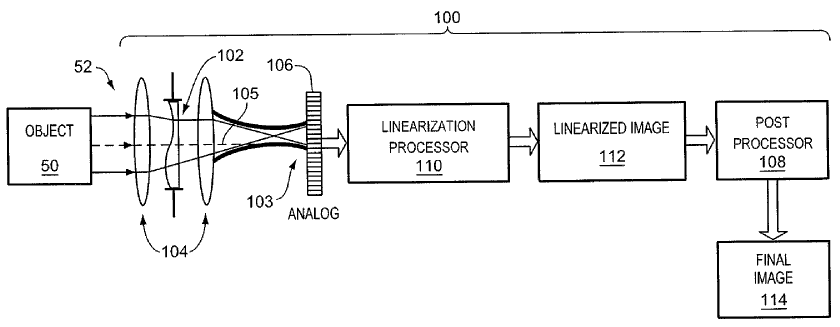

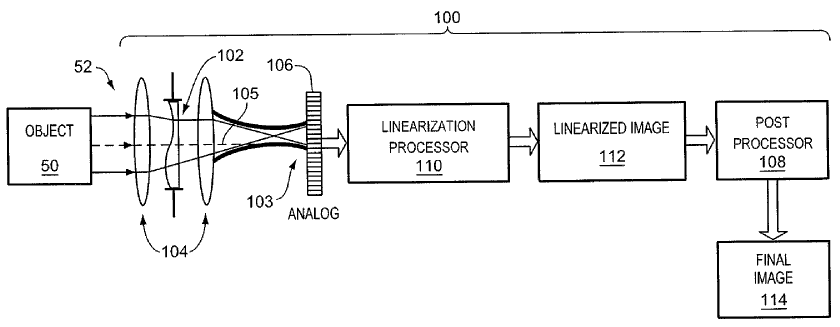

웹사이트에 나와있는 사진은 위와 같이 렌즈 부분을 구체적으로 표시하지 않았고, 다른 특허에서도 "optically-powered unit" 따위의 표현을 쓰고 그냥 단순하게 표시하고 있지만, 좀더 초창기의 문서나 특허를 보면 아래 그림에서의 102번 부품이 말하자면 wavefront encoder 역할을 하는 렌즈임을 알 수 있다.

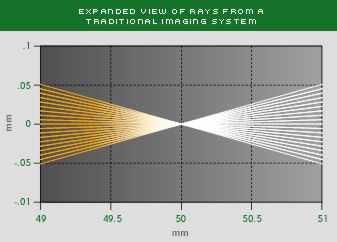

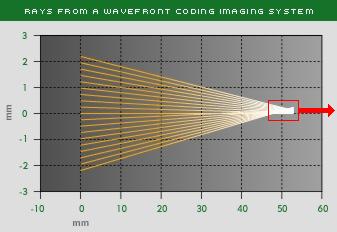

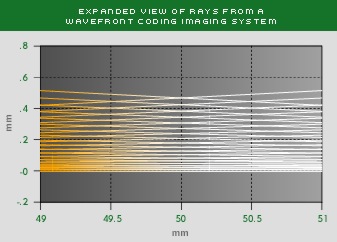

보통의 렌즈라면 아래 첫번째 그림처럼 초점면에 영상이 제대로 맺히겠지만, 위와 같이 꾸불꾸불한 렌즈를 쓰면, 두번째 그림(빨간 네모 부분을 확대한 것이 세번째 그림)처럼 따로 초점이 없이 산란된 이미지가 입력된다.

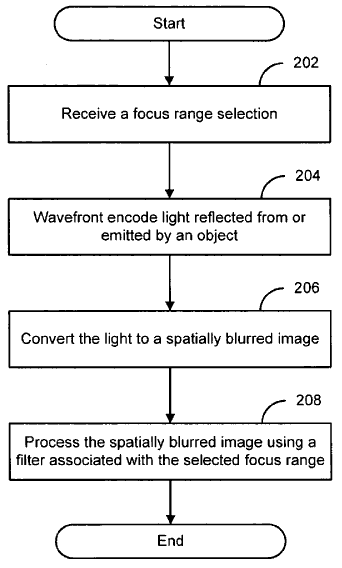

이렇게 입력된 디지털 정보를 원래 렌즈의 미리 입력된 곡률을 바탕으로 다양한 초점거리에 따라 다시 펼 수 있다는 건데. ... 솔직히 나는 여기에서 딱 막혔다. 도대체 이게 어떻게 가능한 건지, 빛의 속도보다 빠른 프로세서가 있다면 모를까 완전히 이해불능. 혹시 이 블로그에 오신 분들 중에서 광학이나 영상처리에 대해서 잘 아시는 분 있다면 꼭(!!!) 좀 설명 달아주기 바란다. ㅡmㅡ

어쨋든 이렇게 된단다. (앞에서 미리 이해가 부족하다고 이실직고 했으니 이 정도로 넘어가 주시길.) 실제로 구동부 하나없이 - 액체렌즈도 없이 ;ㅁ; - 초점조절을 하고 있는 걸 직접 봤으니 뭐 할 말 없다.

... 이 정도는 돼야 Breakthrough라고 할 수 있겠지. 휴. 대단하다. 액체렌즈 따위는 저멀리 날려버린 기술인 듯. 아무리 비교해봐도 액체렌즈 연구가 계속될만한 이유를 못 찾겠다. (개인적으로 지지하던 기술이었는데! z(T^T)s )

기술과 관련된 3개의 특허들은 2004년과 2006년에 출원된(filed) 것들로 비교적 최근의 기술이라고 볼 수 있겠다. 콜로라도 대학에서 두 교수가 발명한 기술로 CDM Optics 라는 회사를 차리고, 이 회사가 2005년 OmniVision에 합병되면서 본격적인 제품화가 시작되었던 듯. 특허는 콜로라도 대학 소유지만 이 교수들이 창업한 회사에서 독자적인 행사권을 가지고 있다고 한다.

개인적으로 흥미로운 것은 2006년 출원된 다른 하나의 특허가 바로 iPhone에 적용된 터치스크린과 초점변동을 다루고 있는데, 그 발명자 이름이 Jess Jan Young Lee로 한국사람이 아닐까 싶다는 점이다. 일전에도 말했듯이 터치스크린으로 초점영역을 설정하는 것 자체는 2005년에 나온 기술이고 특허는 단순히 조합하는 정도의 내용이므로 이 특허가 최종적으로 등록될 것 같지는 않아 보이지만서도. -_-a;;

개인적으로 흥미로운 것은 2006년 출원된 다른 하나의 특허가 바로 iPhone에 적용된 터치스크린과 초점변동을 다루고 있는데, 그 발명자 이름이 Jess Jan Young Lee로 한국사람이 아닐까 싶다는 점이다. 일전에도 말했듯이 터치스크린으로 초점영역을 설정하는 것 자체는 2005년에 나온 기술이고 특허는 단순히 조합하는 정도의 내용이므로 이 특허가 최종적으로 등록될 것 같지는 않아 보이지만서도. -_-a;;

굳이 Wavefront Coding을 이용한 TrueFocus 기술이 아니더라도, 이 회사의 다른 특허들이나 홍보자료를 보면 카메라가 저조도에 민감하게 하는 방법을 포함해서 꽤 많은 수가 검색되고 있다. 위와 같은 특허를 가지고 있다면 Apple사와 계약할 때 배타적인 조건을 안 넣었거나 시한부로 넣었을 것 같은데, 어떤 경우든지 소형 카메라 센서를 넣어야 하는 제조사에서는 이미 상당히 높은 관심을 가지고 있을 것 같은 기업이다.

최근의 홍보자료를 보면 HD화면을 입력받을 수 있는 카메라 센서도 만들었다고는 하는데, 이 센서들에서도 TrueFocus 기술은 들어간 것 같으니 한번 기대해 봄직 하겠다. 아무리 iPhone 3GS라고 해도 HD 화면이라면 실시간 처리는 어렵겠고, 아마 촬영화면 따로, 저장할 이미지는 나중에 따로 처리하게 될지도 모르겠지만, 그런 뒷단의 애환은 사용자에겐 (그리고 UI 디자이너에겐) 그저 고마울 뿐 큰 관심은 없는 영역이니까. ^^* (엔지니어 분들 지못미 ;ㅁ; ㅈㅅ )

OmniVision Technologies의 웹사이트를 구석구석 읽어보면, 중간중간 나타나는 TrueFocus(TM)라는 기술이 아마도 그 핵심이 아닐까 싶다. 이 기술에 대해서는 뭐 당연히... 웹사이트에 친절하게 설명되어 있지는 않지만, 사이트 한 구석을 보면 자회사로 등록되어 있는 OmniVision CDM Optics Inc.에서 Wavefront Coding(TM) Technology 라는 걸 이용해서 소형 카메라의 초점범위를 넓히는 기술을 특허로 가지고 있다는 걸 알 수 있다. 그래도 바로 특허검색.

... 결과는, 앞서 액체렌즈 운운했던 내가 바보같이 느껴지는 내용들이다.

특허 내용 자체는 일주일 넘게 껴안고 짬짬이 읽어봤지만 나로서는 100% 이해하는 게 불가능. 예전 같으면 광학 전문가가 같은 건물 어딘가에 있어서 도움을 받았겠지만, 지금은 주변 동료들의 전문분야가 훨씬 더 다양해지는 바람에 공학 전문가를 찾기가 오히려 힘든 상황이니 뭐. ㅡ_ㅡa;; ... 해서 포기하고, 그냥 몇가지 그림이나 따다놓고 내가 이해한 내용이나 정리해 두기로 했다. 기술에 대한 자세한 (그리고 아마도 올바른) 설명은 위키피디아나 CDM Optics사 웹사이트에 설명되어 있으며, 관련논문(1, 2)도 올라와 있다.

이 wavefront coding에 대한 그나마 해독 -_- 가능했던 설명은 위 CDM Optics사에서 찾아볼 수 있었는데, "특별하게 깎은 렌즈를 통과해서 의도적으로 산란시킨(encoding) 빛을, 그 렌즈의 산란을 역으로 계산하는 알고리듬으로 다시 원래의 영상으로 변환함으로써(decoding), 초점의 깊이/심도를 소프트웨어 적으로 유연하게 조절하고 사진의 전반적인 품질을 높일 수 있는 기술"인 듯 하다.

웹사이트에 나와있는 사진은 위와 같이 렌즈 부분을 구체적으로 표시하지 않았고, 다른 특허에서도 "optically-powered unit" 따위의 표현을 쓰고 그냥 단순하게 표시하고 있지만, 좀더 초창기의 문서나 특허를 보면 아래 그림에서의 102번 부품이 말하자면 wavefront encoder 역할을 하는 렌즈임을 알 수 있다.

보통의 렌즈라면 아래 첫번째 그림처럼 초점면에 영상이 제대로 맺히겠지만, 위와 같이 꾸불꾸불한 렌즈를 쓰면, 두번째 그림(빨간 네모 부분을 확대한 것이 세번째 그림)처럼 따로 초점이 없이 산란된 이미지가 입력된다.

|

|

|

이렇게 입력된 디지털 정보를 원래 렌즈의 미리 입력된 곡률을 바탕으로 다양한 초점거리에 따라 다시 펼 수 있다는 건데. ... 솔직히 나는 여기에서 딱 막혔다. 도대체 이게 어떻게 가능한 건지, 빛의 속도보다 빠른 프로세서가 있다면 모를까 완전히 이해불능. 혹시 이 블로그에 오신 분들 중에서 광학이나 영상처리에 대해서 잘 아시는 분 있다면 꼭(!!!) 좀 설명 달아주기 바란다. ㅡmㅡ

어쨋든 이렇게 된단다. (앞에서 미리 이해가 부족하다고 이실직고 했으니 이 정도로 넘어가 주시길.) 실제로 구동부 하나없이 - 액체렌즈도 없이 ;ㅁ; - 초점조절을 하고 있는 걸 직접 봤으니 뭐 할 말 없다.

... 이 정도는 돼야 Breakthrough라고 할 수 있겠지. 휴. 대단하다. 액체렌즈 따위는 저멀리 날려버린 기술인 듯. 아무리 비교해봐도 액체렌즈 연구가 계속될만한 이유를 못 찾겠다. (개인적으로 지지하던 기술이었는데! z(T^T)s )

기술과 관련된 3개의 특허들은 2004년과 2006년에 출원된(filed) 것들로 비교적 최근의 기술이라고 볼 수 있겠다. 콜로라도 대학에서 두 교수가 발명한 기술로 CDM Optics 라는 회사를 차리고, 이 회사가 2005년 OmniVision에 합병되면서 본격적인 제품화가 시작되었던 듯. 특허는 콜로라도 대학 소유지만 이 교수들이 창업한 회사에서 독자적인 행사권을 가지고 있다고 한다.

굳이 Wavefront Coding을 이용한 TrueFocus 기술이 아니더라도, 이 회사의 다른 특허들이나 홍보자료를 보면 카메라가 저조도에 민감하게 하는 방법을 포함해서 꽤 많은 수가 검색되고 있다. 위와 같은 특허를 가지고 있다면 Apple사와 계약할 때 배타적인 조건을 안 넣었거나 시한부로 넣었을 것 같은데, 어떤 경우든지 소형 카메라 센서를 넣어야 하는 제조사에서는 이미 상당히 높은 관심을 가지고 있을 것 같은 기업이다.

최근의 홍보자료를 보면 HD화면을 입력받을 수 있는 카메라 센서도 만들었다고는 하는데, 이 센서들에서도 TrueFocus 기술은 들어간 것 같으니 한번 기대해 봄직 하겠다. 아무리 iPhone 3GS라고 해도 HD 화면이라면 실시간 처리는 어렵겠고, 아마 촬영화면 따로, 저장할 이미지는 나중에 따로 처리하게 될지도 모르겠지만, 그런 뒷단의 애환은 사용자에겐 (그리고 UI 디자이너에겐) 그저 고마울 뿐 큰 관심은 없는 영역이니까. ^^* (엔지니어 분들 지못미 ;ㅁ; ㅈㅅ )

반응형