Touch UI는 2D 입력을 하고... Gesture UI는 3D 입력을 한다. 비록 조작해야 하는 시스템의 대부분이 2D 화면 상에 구현되어 있음에도 불구하고, 이 구분만큼은 각각의 UI 기술을 연구개발하는 사람들의 배경 만큼이나 확실히 구분되는 듯 하다.

확실히 기존의 Gesture UI는 휴대폰이나 리모컨, 아니면 손을 흔드는 것처럼 3D 공간에서의 움직임을 인식해서 이를 어떤 명령으로 전달하고자 했지만, 최근 눈에 밟힌 2개의 기사에서는 조금 다른 방식의 gesture를 다루고 있다.

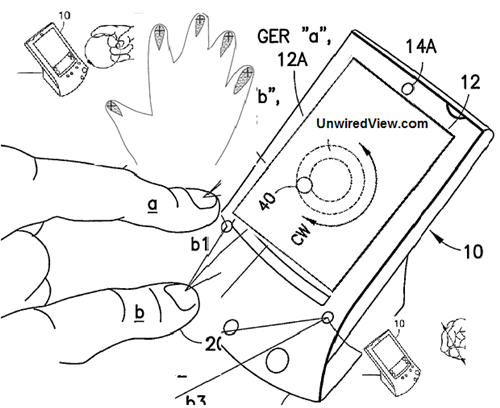

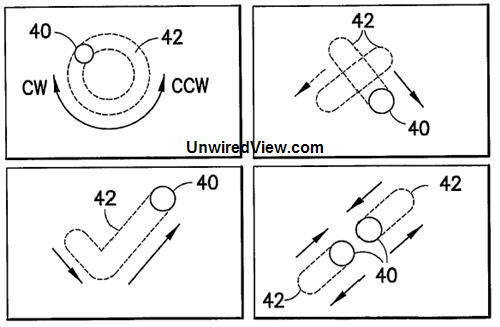

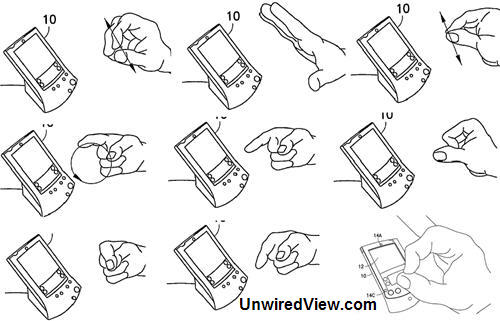

첫번째 기사는 Nokia에서 낸 특허에 대한 것으로, 2개의 적외선 카메라(광학센서)를 이용해 인식한 손가락들의 움직임을 인식하여 pointing이나 다른 명령을 위해 사용하는 발명이다. 한때 열심히 고심했던 연구 과제와 구성이 똑같다는 건 뭐 아쉬운 일이지만, 어쨋든 유행하는 multi-touch와 별도로 독특한 HTI 솔루션을 냈다는 것은 훌륭하다고 생각한다. 단지 모바일 기기를 저렇게 양손 둘째 손가락으로 쓰고 있는 모습이 영화에서처럼 쿨할지는 모르겠지만. ㅡ_ㅡ;;;

두번째 기사는 이번 CES에 나왔던 거리인식 웹캠 업체에 대한 것이다. 특정지점으로부터의 거리를 구하는 것은 레이저를 이용한 방법 등이 많이 쓰였지만, 레이저의 방향을 이리저리 돌려가며 특정 영역의 각 지점까지의 거리를 구하기 위해서는 레이저를 모든 영역으로 한번씩 scan해 줄 수 있도록, 모터와 프리즘이 동원되는 복잡하고 정밀한 시스템이 필요하다. 하지만 이 업체에서는 현명하게도, 특정 펄스를 피사체에 뿌리고 그 반사시간(빛의!)을 측정해서 반 입체를 인식하는... 어렵지만 가장 정답에 근접한 방법을 쓰고 있다. 비교적 가까운 거리이기에 반사체의 특성(색상, 소재, 정반사율 등)에 많이 영향을 받을 것 같기는 하지만, 그래도 별도의 센서를 다는 것보다는 저렴하고 좋아 보인다.

이 두가지 인식 장치는 전혀 달라보일지 몰라도, 내가 보기엔 모두 2.5D Gesture를 추구하고 있는 점에서 닮아있다. Gesture UI를 말하면 언제나 공간 상의 자유로운 동작이 뭔가 큰 일을 할 것 같지만, 사실 3D Virtual Reality 환경 속에서 조차도 진정한 3D 동작으로 뭘 조작할 일은 없다시피 하다. 기껏해다 물건을 "돌려본다" 정도일까? 그 외에 물건을 한쪽으로 치우거나, 무엇 위에 무엇을 놓거나 하는 동작들은 사실 2D 화면 상의 WIMP 개념에서도 충분히 구현되었던 기능이다.

2D 화면에서 구현된 이런 3D적인 개념을 표현하기 위해서 그림자라든가 볼록한 느낌 등을 이용한 그래픽이 많이 사용되었고, 그런 표현들은 한동안 2.5D 라고 부르기도 했다. 그렇다면 3D 공간에서 이루어지지만 2D에 보다 가까운 동작들도 역시 2.5D라고 해야 하지 않을까?

2.5D Gesture는 기본적으로 기존에 사용하는 mouse와 cursor의 gap을 그대로 유지하면서도, 2.5D GUI에서 2% 아쉬웠던 약간의 입체적 조작 - 즉, 살짝 들어올린다든가 하는 동작이라든가 - 을 부가하고, 여러 깊이 layer를 가진 2D 조작의 조합으로서 몇가지 quasi-mode를 지원하게 될 수도 있을 것이다. 무엇보다 일반적인 Gesture UI들이 허공에서 체조하는 듯한 어색하고 촌스러운 느낌이었던 것에 비해, 위와 같은 장치를 이용한 2.5D UI는 화면에서 약간 떨어진 정도의 공간에서 조작하기 때문에, 촌스럽거나 하기보다 오히려 수정구 주위로 신비롭게 움직이는 마법사의 손가락을 연상시킬지 모르는 일이다.

반응형