어제 막을 내린 ACM SIGGRAPH에 대한 소식 중에서, 따로 '미래적인 인터페이스'라고 모아놓은 기사를 보게됐다. ACM 웹사이트에 올라온 기사라고 해도 얼마나 대표성이 있는지는 모르겠으나, 일단 좀 보자면 다음과 같다.

(1) 초음파 간섭을 이용한 공간 상의 촉각 디스플레이

기술적으로는 한꺼번에 몇군데에 압력을 생성할 수 있는지, 그리고 그 해상도가 얼마나 되는지 등등은 좀 확인해볼 필요가 있겠다. 사람이 디스플레이 안에 머리를 들이밀면 안 된다든가 (그 압력이 고막이나 안구에 적용된다면 상당히 끔찍할꺼다), 압력은 좀 느껴지지만 결국은 바람에 지나지 않는다든가, 무엇보다 압력의 방향이 한쪽뿐이라는 건 약점이 되겠지만.

(2) 다중카메라의 입체시를 이용한 실시간 3차원 모델링 장치

꽤 어마어마한 규모의 장비가 들어가야 하니 상용화는 쉽지 않겠지만, 사람을 실시간으로 3차원 공간에 놓을 수 있게 되면서 여러가지 재미있는 인터랙션을 구현한 것은 무척 재미있다. 어쩌면 일전에 소개했던 Oblong의 시스템에 맞물려 재미있는 결과가 나올 수도 있지 않을까.

(3) 증강현실을 이용한 게임

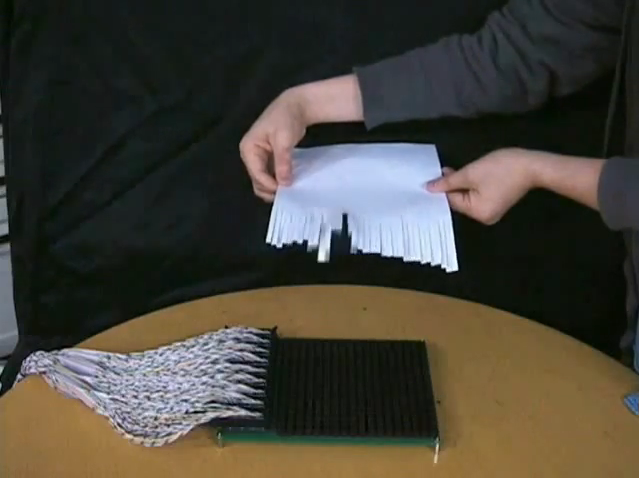

(4) 긁는 소리의 패턴으로 긁은 모양을 유추하는 기술

벽에 터치를 하는 소리로 터치 유무와 위치를 알아낸다든가, 특정한 패턴이 있는 물체를 긁는 소리를 인식해서 어느 부위를 긁는지 알아낸다든가 하는 기술에 이어서, 이번에는 벽을 긁는 고주파음의 패턴 - 손톱이 지나가는 속력에 따라서 달라지는 일차원적인 음높이의 변화 - 을 인식하는 기술을 들고나온 팀이 있다.

단순한 만큼 확장가능성은 높지만, 사용자가 의도하지 않은 오인식의 가능성은 높을 것 같다. 음성인식 때에도 그랬듯이, 먼저 특정하게 정해진 패턴에 이어서 조작명령을 입력한다든가 하는 사용법이 필요할 수 있을 듯. (예를 들면 항상 똑똑 두들긴 후에 명령에 해당하는 문자를 입력한다든가.) 결국은 동작 UI이기 때문에 많은 명령을 한꺼번에 적용할 수 없고 사람마다 차이가 크다는 문제는 있겠지만, 특히 마이크 하나만 있으면 적용이 가능하다는 점을 생각해 보면 아주 간단한 조작 - 이를테면 조명등이라든가, 데모에 나온대로 간단한 휴대폰 기능 등 - 에 대해서는 꽤나 가능성 높아 보이는 제안이다.

(5) 입체영상을 이용한 다자간 영상통화

따로 CSCW라고 불리는 분야가 있을 정도로, 여러 사람이 동시에 하나의 컴퓨터 시스템을 사용하는 상황은 자주 연구되는 주제이다. 하지만 군대 작전통제실과 같은 경우를 제외하고, 그런 상황이 실제로 자주 필요한 경우는 없는 것도 사실인 것 같다. 그동안 좋은 솔루션이 많이 나왔음에도 실용화된 사례는 거의 본 적이 없다. 아마 이 기술도 당분간은 그렇지 않을까나.

아... 시그라프 가보고 싶다... ( '-')

이건 번역 블로깅도 아니고 전문 블로깅도 아니여~

반응형